え?なんで?w普通の呟きなのにツイッター社にアカウントロックされた件www

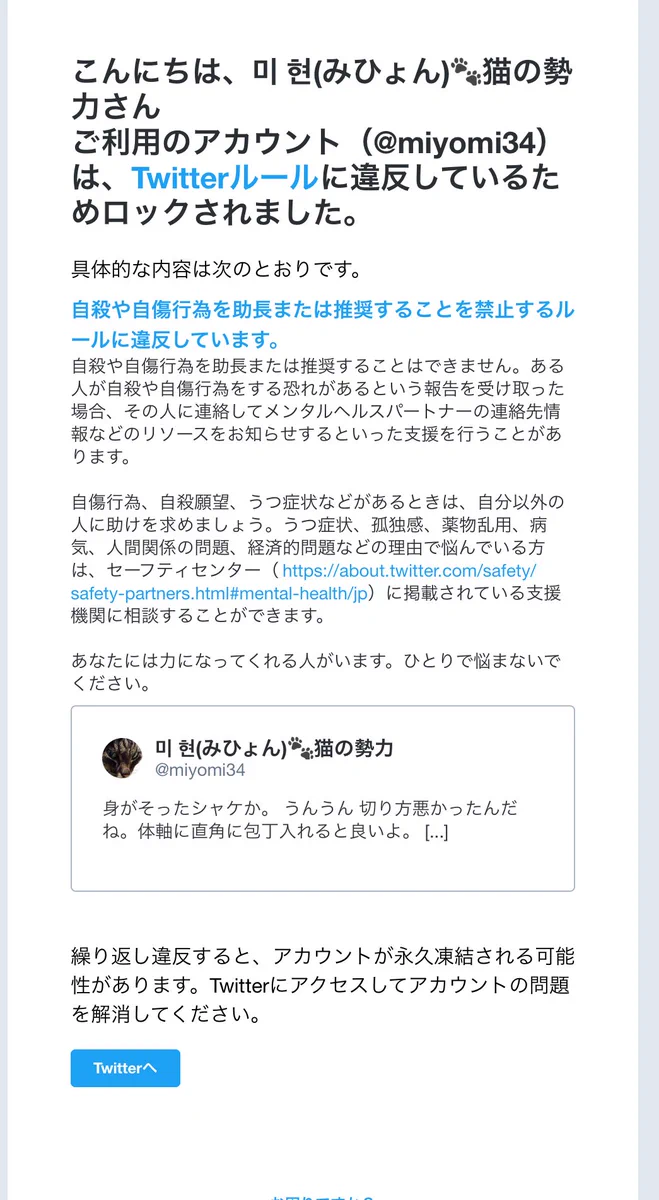

突然Twitterの公式から、自分のアカウントがロックされた!その理由は「自殺や自傷を助長または推奨することを禁止するルールに触れたから」というもの。でも、実際のツイート内容は、そんなことどこにも書いてないんですよね…。

アカウントロックへの反応

mouseion @MouseionS

とらちゃん @triangle83

itochan @itochat

ツイート内容は「鮭の切り方」。

どこに自殺や自傷を推奨したり助長したりする内容があるのでしょうか?

「切る」とか「包丁入れる」というところでしょうか?

いやぁこれでルール違反判定になって、しかも繰り返したら凍結の危険性もあるというのですから、おかしな話ですw

これはTwitter側のAIの判定の甘さが原因なんですよね。

人間が見れば問題ないツイートでも、AIが見れば問題あるツイートになってしまうことがあります。

AIの未熟な判定に振り回されるユーザーは大変ですね。